Les moteurs de recherche sont des répondeurs. Ils existent pour découvrir, comprendre et organiser le contenu d’Internet afin d’offrir les résultats les plus pertinents aux questions que se posent les chercheurs.

Pour apparaître dans les résultats de recherche, votre contenu doit d’abord être visible par les moteurs de recherche. C’est sans doute la pièce la plus importante du puzzle SEO: si votre site ne peut pas être trouvé, vous ne pourrez jamais apparaître dans les SERPs (Search Engine Results Page).

Comment fonctionnent les moteurs de recherche?

Les moteurs de recherche ont trois fonctions principales:

- Exploration: parcourez Internet à la recherche de contenu, en recherchant le code / contenu de chaque URL trouvée.

- Index: stockez et organisez le contenu trouvé pendant le processus d’exploration. Une fois qu’une page est dans l’index, elle est en cours d’exécution pour être affichée à la suite de requêtes pertinentes.

- Classement: fournissez les éléments de contenu qui répondront le mieux à la requête d’un chercheur, ce qui signifie que les résultats sont classés du plus pertinent au moins pertinent.

Qu’est-ce que l’exploration des moteurs de recherche?

L’exploration est le processus de découverte dans lequel les moteurs de recherche envoient une équipe de robots (appelés robots d’exploration ou araignées) pour trouver du contenu nouveau et mis à jour. Le contenu peut varier – il peut s’agir d’une page Web, d’une image, d’une vidéo, d’un PDF, etc. – mais quel que soit le format, le contenu est découvert par des liens.

Que veut dire ce mot?

Vous rencontrez des problèmes avec l’une des définitions de cette section? Notre glossaire SEO a des définitions spécifiques à chaque chapitre pour vous aider à rester à jour.

Bing bot commence par récupérer quelques pages Web, puis suit les liens sur ces pages Web pour trouver de nouvelles URL. En sautant le long de ce chemin de liens, le robot d’exploration est capable de trouver un nouveau contenu et de l’ajouter à son index appelé Caffeine – une énorme base de données d’URL découvertes – pour être récupéré plus tard lorsqu’un chercheur cherche des informations indiquant que le contenu de cette URL est un bon match pour.

Qu’est-ce qu’un index de moteur de recherche?

Les moteurs de recherche traitent et stockent les informations qu’ils trouvent dans un index, une énorme base de données de tout le contenu qu’ils ont découvert et qu’ils jugent assez bon pour servir aux chercheurs.

Classement des moteurs de recherche

Lorsqu’une personne effectue une recherche, les moteurs de recherche parcourent leur index à la recherche d’un contenu hautement pertinent, puis ordonne ce contenu dans l’espoir de résoudre la requête du chercheur. Cet ordre des résultats de recherche par pertinence est appelé classement. En général, vous pouvez supposer que plus un site Web est classé, plus le moteur de recherche pense que ce site est pertinent pour la requête.

Il est possible de bloquer les robots des moteurs de recherche sur une partie ou la totalité de votre site, ou de demander aux moteurs de recherche d’éviter de stocker certaines pages dans leur index. Bien qu’il puisse y avoir des raisons de le faire, si vous voulez que votre contenu soit trouvé par les chercheurs, vous devez d’abord vous assurer qu’il est accessible aux robots d’exploration et qu’il est indexable. Sinon, c’est aussi bien qu’invisible.

À la fin de ce chapitre, vous aurez le contexte dont vous avez besoin pour travailler avec le moteur de recherche, plutôt que contre lui!

En SEO, tous les moteurs de recherche ne sont pas égaux

De nombreux débutants s’interrogent sur l’importance relative de certains moteurs de recherche. La plupart des gens savent que Google détient la plus grande part de marché, mais quelle est l’importance de l’optimisation pour Bing, Yahoo et autres? La vérité est que malgré l’existence de plus de 30 principaux moteurs de recherche Web , la communauté SEO ne prête vraiment attention qu’à Google. Pourquoi? La réponse courte est que Google est l’endroit où la grande majorité des gens recherchent sur le Web. Si nous incluons Google Images, Google Maps et YouTube (une propriété de Google), plus de 90% des recherches sur le Web se produisent sur Google, soit près de 20 fois Bing et Yahoo combinés.

Exploration: les moteurs de recherche peuvent-ils trouver vos pages?

Comme vous venez de l’apprendre, vous assurer que votre site est exploré et indexé est une condition préalable pour apparaître dans les SERPs. Si vous avez déjà un site Web, il peut être judicieux de commencer par voir le nombre de vos pages dans l’index. Cela vous permettra de savoir si Google explore et trouve toutes les pages que vous souhaitez, et aucune que vous ne le faites.

Une façon de vérifier vos pages indexées est “site: votredomaine.com”, un opérateur de recherche avancée . Rendez-vous sur Google et tapez “site: votredomaine.com” dans la barre de recherche. Cela renverra les résultats que Google a dans son index pour le site spécifié:

Le nombre de résultats affichés par Google (voir «Environ XX résultats» ci-dessus) n’est pas exact, mais il vous donne une idée précise des pages indexées sur votre site et de la manière dont elles apparaissent actuellement dans les résultats de recherche.

Pour des résultats plus précis, surveillez et utilisez le rapport de couverture de l’index dans Google Search Console. Vous pouvez vous inscrire pour un compte

Comme nous l’avons mentionné au chapitre 1 , les moteurs de recherche sont des répondeurs. Ils existent pour découvrir, comprendre et organiser le contenu d’Internet afin d’offrir les résultats les plus pertinents aux questions que se posent les chercheurs.

Pour apparaître dans les résultats de recherche, votre contenu doit d’abord être visible par les moteurs de recherche. C’est sans doute la pièce la plus importante du puzzle SEO: si votre site ne peut pas être trouvé, vous ne pourrez jamais apparaître dans les SERPs (Search Engine Results Page).

Comment fonctionnent les moteurs de recherche?

Les moteurs de recherche ont trois fonctions principales:

- Exploration: parcourez Internet à la recherche de contenu, en recherchant le code / contenu de chaque URL trouvée.

- Index: stockez et organisez le contenu trouvé pendant le processus d’exploration. Une fois qu’une page est dans l’index, elle est en cours d’exécution pour être affichée à la suite de requêtes pertinentes.

- Classement: fournissez les éléments de contenu qui répondront le mieux à la requête d’un chercheur, ce qui signifie que les résultats sont classés du plus pertinent au moins pertinent.

Qu’est-ce que l’exploration des moteurs de recherche?

L’exploration est le processus de découverte dans lequel les moteurs de recherche envoient une équipe de robots (appelés robots d’exploration ou araignées) pour trouver du contenu nouveau et mis à jour. Le contenu peut varier – il peut s’agir d’une page Web, d’une image, d’une vidéo, d’un PDF, etc. – mais quel que soit le format, le contenu est découvert par des liens.

Que veut dire ce mot?

Vous rencontrez des problèmes avec l’une des définitions de cette section? Notre glossaire SEO a des définitions spécifiques à chaque chapitre pour vous aider à rester à jour.

Googlebot commence par récupérer quelques pages Web, puis suit les liens sur ces pages Web pour trouver de nouvelles URL. En sautant le long de ce chemin de liens, le robot d’exploration est capable de trouver un nouveau contenu et de l’ajouter à son index appelé Caffeine – une énorme base de données d’URL découvertes – pour être récupéré plus tard lorsqu’un chercheur cherche des informations indiquant que le contenu de cette URL est un bon match pour.

Qu’est-ce qu’un index de moteur de recherche?

Les moteurs de recherche traitent et stockent les informations qu’ils trouvent dans un index, une énorme base de données de tout le contenu qu’ils ont découvert et qu’ils jugent assez bon pour servir aux chercheurs.

Classement des moteurs de recherche

Lorsqu’une personne effectue une recherche, les moteurs de recherche parcourent leur index à la recherche d’un contenu hautement pertinent, puis ordonne ce contenu dans l’espoir de résoudre la requête du chercheur. Cet ordre des résultats de recherche par pertinence est appelé classement. En général, vous pouvez supposer que plus un site Web est classé, plus le moteur de recherche pense que ce site est pertinent pour la requête.

Il est possible de bloquer les robots des moteurs de recherche sur une partie ou la totalité de votre site, ou de demander aux moteurs de recherche d’éviter de stocker certaines pages dans leur index. Bien qu’il puisse y avoir des raisons de le faire, si vous voulez que votre contenu soit trouvé par les chercheurs, vous devez d’abord vous assurer qu’il est accessible aux robots d’exploration et qu’il est indexable. Sinon, c’est aussi bien qu’invisible.

À la fin de ce chapitre, vous aurez le contexte dont vous avez besoin pour travailler avec le moteur de recherche, plutôt que contre lui!

En SEO, tous les moteurs de recherche ne sont pas égaux

De nombreux débutants s’interrogent sur l’importance relative de certains moteurs de recherche. La plupart des gens savent que Google détient la plus grande part de marché, mais quelle est l’importance de l’optimisation pour Bing, Yahoo et autres? La vérité est que malgré l’existence de plus de 30 principaux moteurs de recherche Web , la communauté SEO ne prête vraiment attention qu’à Google. Pourquoi? La réponse courte est que Google est l’endroit où la grande majorité des gens recherchent sur le Web. Si nous incluons Google Images, Google Maps et YouTube (une propriété de Google), plus de 90% des recherches sur le Web se produisent sur Google, soit près de 20 fois Bing et Yahoo combinés.

Exploration: les moteurs de recherche peuvent-ils trouver vos pages?

Comme vous venez de l’apprendre, vous assurer que votre site est exploré et indexé est une condition préalable pour apparaître dans les SERPs. Si vous avez déjà un site Web, il peut être judicieux de commencer par voir le nombre de vos pages dans l’index. Cela vous permettra de savoir si Google explore et trouve toutes les pages que vous souhaitez, et aucune que vous ne le faites.

Une façon de vérifier vos pages indexées est “site: votredomaine.com”, un opérateur de recherche avancée . Rendez-vous sur Google et tapez “site: votredomaine.com” dans la barre de recherche. Cela renverra les résultats que Google a dans son index pour le site spécifié:

Le nombre de résultats affichés par Google (voir «Environ XX résultats» ci-dessus) n’est pas exact, mais il vous donne une idée précise des pages indexées sur votre site et de la manière dont elles apparaissent actuellement dans les résultats de recherche.

Pour des résultats plus précis, surveillez et utilisez le rapport de couverture de l’index dans Google Search Console. Vous pouvez vous inscrire pour un compte Google Search Console gratuit si vous n’en avez pas actuellement. Avec cet outil, vous pouvez soumettre des plans de site pour votre site et surveiller le nombre de pages soumises qui ont effectivement été ajoutées à l’index de Google, entre autres.

Si vous n’apparaissez nulle part dans les résultats de recherche, il existe plusieurs raisons possibles:

- Votre site est tout nouveau et n’a pas encore été exploré.

- Votre site n’est lié à aucun site Web externe.

- La navigation de votre site rend difficile pour un robot de l’explorer efficacement.

- Votre site contient du code de base appelé directives de robot d’exploration qui bloque les moteurs de recherche.

- Votre site a été sanctionné par Google pour des tactiques de spam.

Dites aux moteurs de recherche comment explorer votre site

Si vous avez utilisé Google Search Console ou l’opérateur de recherche avancée “site: domaine.com” et que vous constatez que certaines de vos pages importantes ne figurent pas dans l’index et / ou que certaines de vos pages sans importance ont été indexées par erreur, vous pouvez procéder à des optimisations. mettre en œuvre pour mieux orienter Googlebot sur la manière dont vous souhaitez que votre contenu Web soit analysé. Expliquer aux moteurs de recherche comment explorer votre site peut vous donner un meilleur contrôle de ce qui se termine dans l’index.

La plupart des gens pensent à s’assurer que Google peut trouver leurs pages importantes, mais il est facile d’oublier qu’il y a probablement des pages que vous ne voulez pas que Googlebot trouve. Ceux-ci peuvent inclure des éléments tels que les anciennes URL au contenu léger, les URL en double (comme les paramètres de tri et de filtrage pour le commerce électronique), les pages de code promotionnel spéciales, les pages de test ou de test, etc.

Pour éloigner Googlebot de certaines pages et sections de votre site, utilisez le fichier robots.txt.

Robots.txt

Les fichiers Robots.txt sont situés dans le répertoire racine des sites Web (par exemple, votredomaine.com/robots.txt) et suggèrent quelles parties de votre site les moteurs de recherche doivent et ne doivent pas explorer, ainsi que la vitesse à laquelle ils explorent votre site. , via des directives robots.txt spécifiques .

Comment Googlebot traite les fichiers robots.txt

- Si Googlebot ne trouve pas de fichier robots.txt pour un site, il procède à l’exploration du site.

- Si Googlebot trouve un fichier robots.txt pour un site, il se conformera généralement aux suggestions et procédera à l’exploration du site.

- Si Googlebot rencontre une erreur lors de la tentative d’accès au fichier robots.txt d’un site et ne peut pas déterminer s’il en existe un ou non, il n’explorera pas le site.

Optimisez le budget d’exploration!

Le budget d’exploration est le nombre moyen d’URL que Googlebot explorera sur votre site avant de partir.L’optimisation du budget d’exploration garantit donc que Googlebot ne perd pas de temps à parcourir vos pages sans importance au risque d’ignorer vos pages importantes. Le budget d’exploration est le plus important sur les très grands sites avec des dizaines de milliers d’URL , mais ce n’est jamais une mauvaise idée d’empêcher les robots d’accéder au contenu dont vous ne vous souciez certainement pas. Assurez-vous simplement de ne pas bloquer l’accès d’un robot d’exploration aux pages sur lesquelles vous avez ajouté d’autres directives, telles que les balises canoniques ou noindex. Si Googlebot est bloqué à partir d’une page, il ne pourra pas voir les instructions sur cette page.

Tous les robots Web ne suivent pas le fichier robots.txt. Les personnes avec de mauvaises intentions (par exemple, des grattoirs d’adresses e-mail) construisent des bots qui ne suivent pas ce protocole. En fait, certains acteurs malveillants utilisent des fichiers robots.txt pour trouver où vous avez localisé votre contenu privé. Bien qu’il puisse sembler logique de bloquer les robots d’exploration des pages privées telles que les pages de connexion et d’administration afin qu’ils n’apparaissent pas dans l’index, placer l’emplacement de ces URL dans un fichier robots.txt accessible au public signifie également que les personnes ayant une intention malveillante peut plus facilement les trouver. Il est préférable de NoIndexer ces pages et de les bloquer derrière un formulaire de connexion plutôt que de les placer dans votre fichier robots.txt.

Vous pouvez lire plus de détails à ce sujet dans la partie robots.txt de notre centre de formation .

Définition des paramètres d’URL dans GSC

Certains sites (les plus courants avec le commerce électronique) rendent le même contenu disponible sur plusieurs URL différentes en ajoutant certains paramètres aux URL. Si vous avez déjà effectué des achats en ligne, vous avez probablement affiné votre recherche via des filtres. Par exemple, vous pouvez rechercher des «chaussures» sur Amazon, puis affiner votre recherche par taille, couleur et style. Chaque fois que vous affinez, l’URL change légèrement:

https://www.example.com/products/women/dresses/green.htmhttps://www.example.com/products/women?category=dresses&color=greenhttps://example.com/shopindex.php?product_id= 32 & highlight = vert + robe & cat_id = 1 & sessionid = 123 $ affid = 43

Comment Google sait-il quelle version de l’URL servir aux chercheurs? Google fait un très bon travail pour déterminer l’URL du représentant par lui-même, mais vous pouvez utiliser la fonctionnalité Paramètres d’URL dans Google Search Console pour dire à Google exactement comment vous voulez qu’ils traitent vos pages. Si vous utilisez cette fonctionnalité pour indiquer à Googlebot “n’explorer aucune URL avec le paramètre ____”, vous demandez essentiellement de masquer ce contenu à Googlebot, ce qui pourrait entraîner la suppression de ces pages des résultats de recherche. C’est ce que vous voulez si ces paramètres créent des pages en double, mais pas idéal si vous voulez que ces pages soient indexées.

Les robots d’exploration peuvent-ils trouver tout votre contenu important?

Maintenant que vous connaissez certaines tactiques pour vous assurer que les robots des moteurs de recherche restent à l’écart de votre contenu sans importance, découvrons les optimisations qui peuvent aider Googlebot à trouver vos pages importantes.

Parfois, un moteur de recherche pourra trouver des parties de votre site en explorant, mais d’autres pages ou sections peuvent être masquées pour une raison ou une autre. Il est important de vous assurer que les moteurs de recherche sont en mesure de découvrir tout le contenu que vous souhaitez indexer, et pas seulement votre page d’accueil.

Posez-vous la question suivante: le bot peut-il parcourir votre site Web, et pas seulement vers lui?

Votre contenu est-il caché derrière les formulaires de connexion?

Si vous demandez aux utilisateurs de se connecter, de remplir des formulaires ou de répondre à des sondages avant d’accéder à certains contenus, les moteurs de recherche ne verront pas ces pages protégées. Un robot d’exploration ne va certainement pas se connecter.

Utilisez-vous des formulaires de recherche?

Les robots ne peuvent pas utiliser les formulaires de recherche. Certaines personnes pensent que si elles placent un champ de recherche sur leur site, les moteurs de recherche pourront trouver tout ce que leurs visiteurs recherchent.

Le texte est-il masqué dans le contenu non textuel?

Les formulaires multimédias non textuels (images, vidéo, GIF, etc.) ne doivent pas être utilisés pour afficher le texte que vous souhaitez indexer. Alors que les moteurs de recherche améliorent la reconnaissance des images, il n’y a aucune garantie qu’ils seront capables de les lire et de les comprendre pour l’instant. Il est toujours préférable d’ajouter du texte dans le balisage <HTML> de votre page Web.

Les moteurs de recherche peuvent-ils suivre la navigation de votre site?

Tout comme un robot d’exploration a besoin de découvrir votre site via des liens d’autres sites, il a besoin d’un chemin de liens sur votre propre site pour le guider de page en page. Si vous souhaitez que les moteurs de recherche trouvent une page, mais qu’elle n’est liée à aucune autre page, elle est presque invisible. De nombreux sites font l’erreur critique de structurer leur navigation de manière inaccessible aux moteurs de recherche, ce qui entrave leur capacité à figurer dans les résultats de recherche.

Erreurs de navigation courantes qui peuvent empêcher les robots d’exploration de voir l’intégralité de votre site:

- Avoir une navigation mobile qui affiche des résultats différents de la navigation de votre bureau

- Tout type de navigation où les éléments de menu ne sont pas dans le HTML, comme les navigations activées pour JavaScript. Google s’est beaucoup amélioré dans l’exploration et la compréhension de Javascript, mais ce n’est toujours pas un processus parfait . Le moyen le plus sûr de s’assurer que quelque chose est trouvé, compris et indexé par Google est de le mettre dans le HTML.

- La personnalisation, ou l’affichage d’une navigation unique vers un type spécifique de visiteur par rapport à d’autres, peut sembler être dissimulé à un robot d’exploration de moteur de recherche

- Oublier de créer un lien vers une page principale de votre site Web via votre navigation – rappelez-vous que les liens sont les chemins que les robots d’exploration suivent pour accéder aux nouvelles pages!

C’est pourquoi il est essentiel que votre site Web ait une navigation claire et des structures de dossiers URL utiles.

Avez-vous une architecture d’information propre?

L’architecture de l’information est la pratique consistant à organiser et à étiqueter le contenu d’un site Web pour améliorer l’efficacité et la trouvabilité pour les utilisateurs. La meilleure architecture d’information est intuitive, ce qui signifie que les utilisateurs ne devraient pas avoir à réfléchir très fort pour parcourir votre site Web ou pour trouver quelque chose.

Utilisez-vous des sitemaps?

Un plan de site est exactement ce à quoi il ressemble: une liste d’URL sur votre site que les robots d’exploration peuvent utiliser pour découvrir et indexer votre contenu. L’un des moyens les plus simples de s’assurer que Google trouve vos pages les plus prioritaires consiste à créer un fichier conforme aux normes de Google et à le soumettre via Google Search Console. Bien que la soumission d’un plan du site ne remplace pas la nécessité d’une bonne navigation sur le site, cela peut certainement aider les robots d’exploration à suivre un chemin vers toutes vos pages importantes.

Assurez-vous que vous n’avez inclus que les URL que vous souhaitez indexer par les moteurs de recherche et assurez-vous de donner aux robots d’exploration des directions cohérentes. Par exemple, n’incluez pas d’URL dans votre sitemap si vous avez bloqué cette URL via le fichier robots.txt ou n’incluez pas dans votre sitemap des URL qui sont des doublons plutôt que la version canonique préférée (nous fournirons plus d’informations sur la canonisation dans le chapitre 5 !).

Si aucun autre site n’est lié à votre site, vous pourrez peut-être l’indexer en soumettant votre plan de site XML dans Google Search Console. Il n’y a aucune garantie qu’ils incluront une URL soumise dans leur index, mais cela vaut la peine d’essayer!

Les robots d’exploration obtiennent-ils des erreurs lorsqu’ils tentent d’accéder à vos URL?

Lors du processus d’exploration des URL de votre site, un robot d’exploration peut rencontrer des erreurs. Vous pouvez accéder au rapport “Erreurs d’exploration” de Google Search Console pour détecter les URL sur lesquelles cela pourrait se produire – ce rapport vous montrera les erreurs de serveur et les erreurs non trouvées. Les fichiers journaux du serveur peuvent également vous montrer cela, ainsi qu’un trésor d’autres informations telles que la fréquence d’exploration, mais comme accéder et disséquer les fichiers journaux du serveur est une tactique plus avancée, nous n’en discuterons pas en détail dans le Guide du débutant, bien que vous puissiez en savoir plus ici .

Avant de pouvoir faire quoi que ce soit de significatif avec le rapport d’erreurs d’exploration, il est important de comprendre les erreurs de serveur et les erreurs “non trouvées”.

Codes 4xx: lorsque les robots des moteurs de recherche ne peuvent pas accéder à votre contenu en raison d’une erreur du client

Les erreurs 4xx sont des erreurs client, ce qui signifie que l’URL demandée contient une mauvaise syntaxe ou ne peut pas être remplie. L’une des erreurs 4xx les plus courantes est l’erreur «404 – introuvable». Celles-ci peuvent se produire en raison d’une faute de frappe d’URL, d’une page supprimée ou d’une redirection interrompue, pour ne citer que quelques exemples. Lorsque les moteurs de recherche atteignent un 404, ils ne peuvent pas accéder à l’URL. Lorsque les utilisateurs atteignent un 404, ils peuvent être frustrés et partir.

Codes 5xx: lorsque les robots des moteurs de recherche ne peuvent pas accéder à votre contenu en raison d’une erreur de serveur

Les erreurs 5xx sont des erreurs de serveur, ce qui signifie que le serveur sur lequel se trouve la page Web n’a pas réussi à répondre à la demande du chercheur ou du moteur de recherche d’accéder à la page. Dans le rapport “Erreur d’exploration” de Google Search Console, un onglet est dédié à ces erreurs. Celles-ci se produisent généralement parce que la demande d’URL a expiré. Googlebot a donc abandonné la demande. Consultez la documentation de Google pour en savoir plus sur la résolution des problèmes de connectivité du serveur.

Heureusement, il existe un moyen d’indiquer aux chercheurs et aux moteurs de recherche que votre page a déménagé – la redirection 301 (permanente).

Créez des pages 404 personnalisées!

Personnalisez votre page 404 en ajoutant des liens vers des pages importantes de votre site, une fonction de recherche de site et même des informations de contact. Cela devrait réduire la probabilité que les visiteurs rebondissent sur votre site lorsqu’ils atteignent un 404.

Supposons que vous déplaciez une page de example.com/young-dogs/ vers example.com/puppies/ . Les moteurs de recherche et les utilisateurs ont besoin d’un pont pour passer de l’ancienne URL à la nouvelle. Ce pont est une redirection 301.

| Lorsque vous implémentez un 301: | Lorsque vous n’implémentez pas de 301: | ||

|---|---|---|---|

| Lier l’équité | Transfère l’équité du lien de l’ancien emplacement de la page vers la nouvelle URL. | Sans 301, l’autorité de l’URL précédente n’est pas transmise à la nouvelle version de l’URL. | |

| Indexage | Aide Google à trouver et indexer la nouvelle version de la page. | La présence d’erreurs 404 sur votre site à elle seule ne nuit pas aux performances de recherche, mais laisser les pages de classement / trafiquées 404 peut les faire sortir de l’index, avec le classement et le trafic qui les accompagnent – yikes! | |

| Expérience utilisateur | S’assure que les utilisateurs trouvent la page qu’ils recherchent. | Permettre à vos visiteurs de cliquer sur des liens morts les mènera vers des pages d’erreur au lieu de la page prévue, ce qui peut être frustrant. |

Le code d’état 301 lui-même signifie que la page a été déplacée de manière permanente vers un nouvel emplacement, évitez donc de rediriger les URL vers des pages non pertinentes – des URL où le contenu de l’ancienne URL ne vit pas réellement. Si une page est classée pour une requête et que vous la placez sur une URL avec un contenu différent, sa position de classement peut chuter car le contenu qui l’a rendue pertinente pour cette requête particulière n’existe plus. Les 301 sont puissants – déplacez les URL de manière responsable!

Vous avez également la possibilité de 302 rediriger une page, mais cela devrait être réservé aux déplacements temporaires et dans les cas où le passage de l’équité des liens n’est pas aussi grave. Les 302 sont un peu comme un détour routier. Vous siphonnez temporairement le trafic sur un certain itinéraire, mais ce ne sera pas comme ça pour toujours.

Attention aux chaînes de redirection!

Il peut être difficile pour Googlebot d’accéder à votre page s’il doit passer par plusieurs redirections. Google appelle ces «chaînes de redirection» et recommande de les limiter autant que possible. Si vous redirigez example.com/1 vers example.com/2, puis décidez plus tard de le rediriger vers example.com/3, il est préférable d’éliminer l’intermédiaire et de rediriger simplement example.com/1 vers example.com/3.

Une fois que vous vous êtes assuré que votre site est optimisé pour l’exploration, la prochaine étape consiste à vous assurer qu’il peut être indexé.

1)Comment s’appelle le processus qu’utilisent les moteurs de recherche pour extraire et évaluer les mots des pages web afin de pouvoir répondre aux requêtes des internautes ?

Il s’appelle Indexation.

Une fois que vous vous êtes assuré que votre site a été exploré, la prochaine étape consiste à vous assurer qu’il peut être indexé. C’est vrai – ce n’est pas parce que votre site peut être découvert et exploré par un moteur de recherche qu’il sera stocké dans son index. Dans la section précédente sur l’exploration, nous avons expliqué comment les moteurs de recherche découvrent vos pages Web. L’index est l’endroit où vos pages découvertes sont stockées. Une fois qu’un robot a trouvé une page, le moteur de recherche la restitue comme un navigateur le ferait. Ce faisant, le moteur de recherche analyse le contenu de cette page. Toutes ces informations sont stockées dans son index.

Lisez la suite pour en savoir plus sur le fonctionnement de l’indexation et sur la manière dont vous pouvez vous assurer que votre site est intégré à cette base de données essentielle.

Puis-je voir comment un robot d’exploration Googlebot voit mes pages?

Oui, la version mise en cache de votre page reflétera un instantané de la dernière exploration de Googlebot.

Google explore et met en cache les pages Web à différentes fréquences. Des sites plus établis et bien connus qui publient fréquemment comme https://www.nytimes.com seront explorés plus fréquemment que le site Web beaucoup moins célèbre de l’agitation de Roger the Mozbot, http://www.rogerlovescupcakes.com ( si seulement c’était réel …)

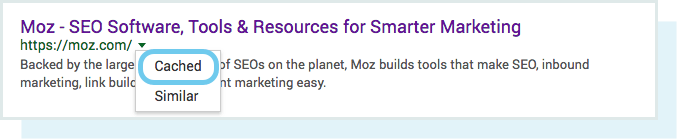

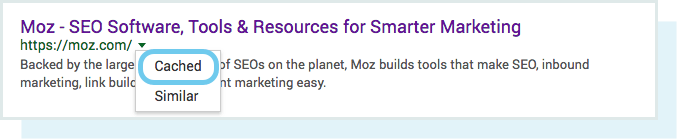

Vous pouvez voir à quoi ressemble votre version mise en cache d’une page en cliquant sur la flèche déroulante à côté de l’URL dans le SERP et en choisissant “En cache”:

Vous pouvez également afficher la version texte de votre site pour déterminer si votre contenu important est analysé et mis en cache de manière efficace.

Des pages sont-elles déjà supprimées de l’index?

Oui, les pages peuvent être supprimées de l’index! Voici quelques-unes des principales raisons pour lesquelles une URL peut être supprimée:

- L’URL renvoie une erreur “introuvable” (4XX) ou une erreur de serveur (5XX) – Cela peut être accidentel (la page a été déplacée et une redirection 301 n’a pas été configurée) ou intentionnelle (la page a été supprimée et 404 modifiée afin de le retirer de l’index)

- Une balise meta noindex a été ajoutée à l’URL – Cette balise peut être ajoutée par les propriétaires de sites pour demander au moteur de recherche d’omettre la page de son index.

- L’URL a été sanctionnée manuellement pour violation des consignes aux webmasters du moteur de recherche et, par conséquent, a été supprimée de l’index.

- L’exploration de l’URL a été bloquée avec l’ajout d’un mot de passe requis pour que les visiteurs puissent accéder à la page.

Si vous pensez qu’une page de votre site Web qui figurait auparavant dans l’index de Google ne s’affiche plus, vous pouvez utiliser l’ outil d’inspection d’URL pour connaître l’état de la page ou utiliser Explorer comme Google, qui dispose d’une fonctionnalité “Demander l’indexation” pour soumettre des URL individuelles à l’index. (Bonus: l’outil “fetch” de GSC a également une option “render” qui vous permet de voir s’il y a des problèmes avec la façon dont Google interprète votre page).

Dites aux moteurs de recherche comment indexer votre site

Directives méta robots

Les directives méta (ou “balises méta”) sont des instructions que vous pouvez donner aux moteurs de recherche concernant la manière dont vous voulez que votre page Web soit traitée.

Vous pouvez dire aux robots des moteurs de recherche des choses comme “ne pas indexer cette page dans les résultats de recherche” ou “ne transmettre aucune équité de lien à des liens sur la page”. Ces instructions sont exécutées via les balises Meta Robots dans le <head> de vos pages HTML (le plus couramment utilisé) ou via le X-Robots-Tag dans l’en-tête HTTP.

Balise Meta Robots

La balise meta robots peut être utilisée dans le <head> du code HTML de votre page Web. Il peut exclure tous ou certains moteurs de recherche. Voici les méta-directives les plus courantes, ainsi que les situations dans lesquelles vous pouvez les appliquer.

index / noindex indique aux moteurs si la page doit être explorée et conservée dans l’index d’un moteur de recherche pour la récupération. Si vous choisissez d’utiliser “noindex”, vous indiquez aux robots d’exploration que vous souhaitez que la page soit exclue des résultats de recherche. Par défaut, les moteurs de recherche supposent qu’ils peuvent indexer toutes les pages, il n’est donc pas nécessaire d’utiliser la valeur «index».

- Utilisation possible: vous pouvez choisir de marquer une page comme “noindex” si vous essayez de découper des pages fines de l’index Google de votre site (par exemple, les pages de profil générées par l’utilisateur), mais que vous souhaitez toujours qu’elles soient accessibles aux visiteurs.

follow / nofollow indique aux moteurs de recherche si les liens de la page doivent être suivis ou non. «Suivre» permet aux robots de suivre les liens sur votre page et de transmettre l’équité des liens à ces URL. Ou, si vous choisissez d’employer “nofollow”, les moteurs de recherche ne suivront ni ne transmettront aucune équité de lien aux liens sur la page. Par défaut, toutes les pages sont supposées avoir l’attribut «suivre».

- Quand vous pouvez utiliser: nofollow est souvent utilisé avec noindex lorsque vous essayez d’empêcher l’indexation d’une page et d’empêcher le robot d’exploration de suivre les liens sur la page.

noarchive est utilisé pour empêcher les moteurs de recherche d’enregistrer une copie en cache de la page. Par défaut, les moteurs conserveront des copies visibles de toutes les pages qu’ils ont indexées, accessibles aux chercheurs via le lien mis en cache dans les résultats de recherche.

- Utilisation: si vous gérez un site de commerce électronique et que vos prix changent régulièrement, vous pouvez envisager la balise noarchive pour empêcher les internautes de voir des prix obsolètes.

Voici un exemple de balise meta robots noindex, nofollow:

<! DOCTYPE html> <html> <head> <meta name = "robots" content = "noindex, nofollow" /> </head> <body> ... </body> </html>

Cet exemple exclut tous les moteurs de recherche d’indexer la page et de suivre les liens sur la page. Si vous souhaitez exclure plusieurs robots d’exploration, comme googlebot et bing par exemple, vous pouvez utiliser plusieurs balises d’exclusion de robot.

Les directives Meta affectent l’indexation, pas l’exploration

Googlebot doit explorer votre page pour voir ses méta-directives, donc si vous essayez d’empêcher les robots d’exploration d’accéder à certaines pages, les méta-directives ne sont pas le moyen de le faire. Les balises des robots doivent être explorées pour être respectées.

X-Robots-Tag

La balise x-robots est utilisée dans l’en-tête HTTP de votre URL, offrant plus de flexibilité et de fonctionnalités que les balises méta si vous souhaitez bloquer les moteurs de recherche à grande échelle, car vous pouvez utiliser des expressions régulières, bloquer les fichiers non HTML et appliquer des balises noindex à l’échelle du site. .

Par exemple, vous pouvez facilement exclure des dossiers entiers ou des types de fichiers (comme moz.com/no-bake/old-recipes-to-noindex):

<Files ~ "\ /? No \ -bake \ /.*"> Ensemble d'en-tête X-Robots-Tag "noindex, nofollow" </Files>

Les dérivés utilisés dans une balise meta robots peuvent également être utilisés dans un tag X-Robots.

Ou des types de fichiers spécifiques (comme les PDF):

<Files ~ "\ .pdf $"> Ensemble d'en-tête X-Robots-Tag "noindex, nofollow" </Files>

Pour plus d’informations sur les balises Meta Robot, explorez les spécifications des balises méta robots de Google .

Astuce WordPress:

Dans Tableau de bord> Paramètres> Lecture, assurez-vous que la case “Visibilité du moteur de recherche” n’est pas cochée. Cela empêche les moteurs de recherche d’accéder à votre site via votre fichier robots.txt!

Comprendre les différentes façons dont vous pouvez influencer l’exploration et l’indexation vous aidera à éviter les pièges courants qui peuvent empêcher la recherche de vos pages importantes.

Classement: comment les moteurs de recherche classent-ils les URL?

Comment les moteurs de recherche s’assurent-ils que lorsqu’un internaute tape une requête dans la barre de recherche, il obtient en retour des résultats pertinents? Ce processus est appelé classement ou classement des résultats de recherche du plus pertinent au moins pertinent pour une requête particulière.

Pour déterminer la pertinence, les moteurs de recherche utilisent des algorithmes, un processus ou une formule par lesquels les informations stockées sont récupérées et classées de manière significative. Ces algorithmes ont subi de nombreux changements au fil des ans afin d’améliorer la qualité des résultats de recherche. Google, par exemple, effectue des ajustements d’algorithme tous les jours – certaines de ces mises à jour sont des ajustements mineurs de qualité, tandis que d’autres sont des mises à jour d’algorithmes de base / générales déployées pour résoudre un problème spécifique, comme Penguin pour lutter contre le spam de lien. Consultez notre historique des modifications de l’algorithme Google pour obtenir une liste des mises à jour Google confirmées et non confirmées remontant à l’an 2000.

Pourquoi l’algorithme change-t-il si souvent? Google essaie-t-il simplement de nous garder sur nos gardes? Bien que Google ne révèle pas toujours les raisons pour lesquelles ils font ce qu’ils font, nous savons que l’objectif de Google lors des ajustements d’algorithmes est d’améliorer la qualité globale de la recherche. C’est pourquoi, en réponse aux questions de mise à jour des algorithmes, Google répondra par quelque chose du genre: “Nous effectuons des mises à jour de qualité tout le temps.” Cela indique que, si votre site a souffert après un ajustement d’algorithme, comparez-le aux directives de qualité de Google ou aux directives de Search Quality Rater , les deux sont très révélateurs en termes de ce que veulent les moteurs de recherche.

Que veulent les moteurs de recherche?

Les moteurs de recherche ont toujours voulu la même chose: fournir des réponses utiles aux questions des chercheurs dans les formats les plus utiles. Si c’est vrai, alors pourquoi semble-t-il que le référencement est différent maintenant de celui des années passées?

Pensez-y en termes de quelqu’un qui apprend une nouvelle langue.

Au début, leur compréhension de la langue est très rudimentaire – «See Spot Run». Au fil du temps, leur compréhension commence à s’approfondir et ils apprennent la sémantique – la signification du langage et la relation entre les mots et les phrases. Finalement, avec suffisamment de pratique, l’élève connaît suffisamment bien la langue pour même comprendre les nuances, et est capable de fournir des réponses à des questions même vagues ou incomplètes.

Lorsque les moteurs de recherche commençaient tout juste à apprendre notre langue, il était beaucoup plus facile de jouer avec le système en utilisant des astuces et des tactiques qui vont à l’encontre des directives de qualité. Prenons l’exemple du bourrage de mots clés. Si vous souhaitez vous classer pour un mot clé particulier tel que “blagues amusantes”, vous pouvez ajouter plusieurs fois les mots “blagues amusantes” sur votre page et le rendre audacieux, dans l’espoir d’améliorer votre classement pour ce terme:

Bienvenue aux blagues drôles ! Nous racontons les blagues les plus drôles du monde. Les blagues drôles sont amusantes et folles. Votre drôle de blague vous attend. Asseyez-vous et lisez des blagues amusantes, car des blagues amusantes peuvent vous rendre heureux et plus drôle . Quelques blagues drôles préférées .

Cette tactique a créé de terribles expériences pour les utilisateurs, et au lieu de rire des blagues amusantes, les gens ont été bombardés par un texte ennuyeux et difficile à lire. Cela a peut-être fonctionné dans le passé, mais ce n’est jamais ce que les moteurs de recherche voulaient.

Le rôle des liens dans le référencement

Quand on parle de liens, on peut vouloir dire deux choses. Les backlinks ou «liens entrants» sont des liens provenant d’autres sites Web qui pointent vers votre site Web, tandis que les liens internes sont des liens sur votre propre site qui pointent vers vos autres pages (sur le même site).

Les liens ont historiquement joué un grand rôle dans le référencement. Très tôt, les moteurs de recherche ont eu besoin d’aide pour déterminer quelles URL étaient plus fiables que d’autres pour les aider à déterminer comment classer les résultats de recherche. Le calcul du nombre de liens pointant vers un site donné les a aidés à le faire.

Les backlinks fonctionnent de manière très similaire aux références réelles WoM (Word-of-Mouth). Prenons un café hypothétique, Jenny’s Coffee, comme exemple:

- Renvois par d’autres = bon signe d’autorité

- Exemple: de nombreuses personnes vous ont toutes dit que Jenny’s Coffee était le meilleur de la ville

- Renvois de vous-même = biaisés, donc pas un bon signe d’autorité

- Exemple: Jenny affirme que Jenny’s Coffee est le meilleur de la ville

- Renvois provenant de sources non pertinentes ou de mauvaise qualité = pas un bon signe d’autorité et pourraient même vous faire signaler pour spam

- Exemple: Jenny a payé pour que des gens qui n’ont jamais visité son café disent aux autres à quel point il est bon.

- Aucune référence = autorité peu claire

- Exemple: Jenny’s Coffee est peut-être bon, mais vous n’avez pas réussi à trouver quelqu’un qui ait une opinion donc vous ne pouvez pas en être sûr.

C’est pourquoi le PageRank a été créé. Le PageRank (qui fait partie de l’algorithme de base de Google) est un algorithme d’analyse de lien nommé d’après l’un des fondateurs de Google, Larry Page. Le PageRank évalue l’importance d’une page Web en mesurant la qualité et la quantité des liens pointant vers elle. L’hypothèse est que plus une page Web est pertinente, importante et digne de confiance, plus elle aura gagné de liens.

Plus vous avez de backlinks naturels à partir de sites Web de haute autorité (de confiance), meilleures sont vos chances de vous classer plus haut dans les résultats de recherche.

Le rôle du contenu dans le référencement

Les liens ne serviraient à rien s’ils ne dirigeaient pas les chercheurs vers quelque chose. Ce quelque chose est content! Le contenu est plus que de simples mots; c’est tout ce qui est destiné à être consommé par les chercheurs – il y a du contenu vidéo, du contenu d’image et, bien sûr, du texte. Si les moteurs de recherche sont des répondeurs, le contenu est le moyen par lequel les moteurs fournissent ces réponses.

Chaque fois que quelqu’un effectue une recherche, il y a des milliers de résultats possibles, alors comment les moteurs de recherche décident-ils quelles pages le chercheur va trouver utile? Une grande partie de la détermination du classement de votre page pour une requête donnée est de savoir dans quelle mesure le contenu de votre page correspond à l’intention de la requête. En d’autres termes, cette page correspond-elle aux mots recherchés et permet-elle d’accomplir la tâche que le chercheur essayait d’accomplir?

En raison de cet accent mis sur la satisfaction des utilisateurs et l’accomplissement des tâches, il n’y a pas de référence stricte sur la durée de votre contenu, le nombre de fois où il doit contenir un mot-clé ou ce que vous mettez dans vos balises d’en-tête. Tous ces éléments peuvent jouer un rôle dans les performances d’une page dans la recherche, mais l’accent doit être mis sur les utilisateurs qui liront le contenu.

Aujourd’hui, avec des centaines, voire des milliers de signaux de classement, les trois premiers sont restés assez cohérents: les liens vers votre site Web (qui servent de signaux de crédibilité tiers), le contenu sur la page (contenu de qualité qui répond à l’intention du chercheur), et RankBrain.

Qu’est-ce que RankBrain?

RankBrain est le composant d’apprentissage automatique de l’algorithme de base de Google. L’apprentissage automatique est un programme informatique qui continue d’améliorer ses prédictions au fil du temps grâce à de nouvelles observations et données d’entraînement. En d’autres termes, il apprend toujours, et comme il apprend toujours, les résultats de recherche devraient s’améliorer constamment.

Par exemple, si RankBrain remarque une URL de rang inférieur fournissant un meilleur résultat aux utilisateurs que les URL de rang supérieur, vous pouvez parier que RankBrain ajustera ces résultats, déplaçant le résultat le plus pertinent vers le haut et rétrogradant les pages les moins pertinentes en tant que sous-produit.

Comme la plupart des choses avec le moteur de recherche, nous ne savons pas exactement ce qui comprend RankBrain, mais apparemment, les gens de Google ne le font pas non plus .

Qu’est-ce que cela signifie pour les référenceurs?

Étant donné que Google continuera à tirer parti de RankBrain pour promouvoir le contenu le plus pertinent et le plus utile, nous devons nous concentrer plus que jamais sur la réalisation de l’intention du chercheur. Fournissez les meilleures informations et expériences possibles aux internautes qui pourraient atterrir sur votre page, et vous avez franchi une première étape importante pour bien performer dans un monde RankBrain.

Mesures d’engagement: corrélation, causalité ou les deux?

Avec les classements Google, les métriques d’engagement sont très probablement une corrélation et une causalité.

Lorsque nous parlons de métriques d’engagement, nous entendons des données qui représentent la manière dont les internautes interagissent avec votre site à partir des résultats de recherche. Cela comprend des choses comme:

- Clics (visites issues de la recherche)

- Temps passé sur la page (temps passé par le visiteur sur une page avant de la quitter)

- Taux de rebond (le pourcentage de toutes les sessions du site Web où les utilisateurs n’ont consulté qu’une seule page)

- Pogo-sticking (en cliquant sur un résultat organique puis en revenant rapidement au SERP pour choisir un autre résultat)

De nombreux tests, y compris l’enquête sur les facteurs de classement de Moz , ont indiqué que les mesures d’engagement sont corrélées à un classement plus élevé, mais la causalité a été vivement débattue. Les bonnes mesures d’engagement sont-elles simplement indicatives de sites hautement classés? Ou les sites sont-ils bien classés parce qu’ils possèdent de bonnes mesures d’engagement?

Ce que Google a dit

Bien qu’ils n’aient jamais utilisé le terme «signal de classement direct», Google a clairement indiqué qu’ils utilisent absolument les données de clic pour modifier le SERP pour des requêtes particulières.

Selon l’ancien chef de la qualité de la recherche de Google , Udi Manber:

«Le classement lui-même est affecté par les données de clic. Si nous découvrons que, pour une requête particulière, 80% des gens cliquent sur le n ° 2 et seulement 10% sur le n ° 1, après un certain temps, nous comprenons que le n ° 2 est probablement celui que les gens veulent, alors nous allons le changer. “

Un autre commentaire de l’ancien ingénieur de Google Edmond Lau corrobore ceci:

«Il est assez clair que tout moteur de recherche raisonnable utiliserait les données de clics sur ses propres résultats pour alimenter le classement afin d’améliorer la qualité des résultats de recherche. Les mécanismes réels d’utilisation des données sur les clics sont souvent exclusifs, mais Google montre clairement qu’il utilise les données de clics avec ses brevets sur des systèmes tels que les éléments de contenu ajustés en fonction du classement. “

Étant donné que Google doit maintenir et améliorer la qualité de la recherche, il semble inévitable que les mesures d’engagement soient plus qu’une simple corrélation, mais il semblerait que Google ne parvienne pas à qualifier les mesures d’engagement de “signal de classement”, car ces mesures sont utilisées pour améliorer la qualité de la recherche le rang des URL individuelles n’est qu’un sous-produit de cela.

Quels tests ont confirmé

Divers tests ont confirmé que Google ajusterait l’ordre SERP en réponse à l’engagement des chercheurs:

- Le test 2014 de Rand Fishkin a abouti à un résultat n ° 7 passant à la première place après avoir amené environ 200 personnes à cliquer sur l’URL du SERP. Il est intéressant de noter que l’amélioration du classement semble être liée à l’emplacement des personnes qui ont visité le lien. La position de classement a augmenté aux États-Unis, où se trouvaient de nombreux participants, alors qu’elle est restée plus basse sur la page dans Google Canada, Google Australie, etc.

- La comparaison de Larry Kim des pages principales et de leur temps de séjour moyen avant et après RankBrain semblait indiquer que le composant d’apprentissage automatique de l’algorithme de Google rétrograde la position de classement des pages sur lesquelles les gens ne passent pas autant de temps.

- Les tests de Darren Shaw ont également montré l’impact du comportement des utilisateurs sur la recherche locale et les résultats du pack de cartes.

Étant donné que les métriques d’engagement des utilisateurs sont clairement utilisées pour ajuster les SERP en fonction de la qualité et classer les changements de position comme un sous-produit, il est prudent de dire que les référenceurs devraient optimiser l’engagement . L’engagement ne change pas la qualité objective de votre page Web, mais plutôt votre valeur pour les chercheurs par rapport aux autres résultats de cette requête. C’est pourquoi, après aucune modification de votre page ou de ses backlinks, le classement pourrait décliner si le comportement des internautes indique qu’ils aiment mieux les autres pages.

En termes de classement des pages Web, les mesures d’engagement agissent comme un vérificateur de faits. Des facteurs objectifs tels que les liens et le contenu classent d’abord la page, puis les métriques d’engagement aident Google à s’ajuster si elles ne l’ont pas bien fait.

L’évolution des résultats de recherche

À l’époque où les moteurs de recherche manquaient beaucoup de la sophistication qu’ils ont aujourd’hui, le terme «10 liens bleus» a été inventé pour décrire la structure plate du SERP. Chaque fois qu’une recherche était effectuée, Google renvoyait une page avec 10 résultats organiques, chacun dans le même format.

Dans ce paysage de recherche, occuper la première place était le Saint Graal du référencement. Mais alors quelque chose est arrivé. Google a commencé à ajouter des résultats dans de nouveaux formats sur leurs pages de résultats de recherche, appelés fonctionnalités SERP . Certaines de ces fonctionnalités SERP incluent:

- Publicités payantes

- Extraits en vedette

- Les gens demandent aussi des boîtes

- Pack local (carte)

- Panneau de connaissances

- Liens annexes

Et Google en ajoute constamment de nouveaux. Ils ont même expérimenté des «SERP à résultat nul», un phénomène où un seul résultat du Knowledge Graph était affiché sur le SERP sans résultats inférieurs à l’exception d’une option permettant «d’afficher plus de résultats».

L’ajout de ces fonctionnalités a provoqué une panique initiale pour deux raisons principales. D’une part, bon nombre de ces fonctionnalités ont entraîné une baisse des résultats organiques sur le SERP. Un autre sous-produit est que moins de chercheurs cliquent sur les résultats organiques, car plus de requêtes sont traitées sur le SERP lui-même.

Alors, pourquoi Google ferait-il cela? Tout revient à l’expérience de recherche. Le comportement de l’utilisateur indique que certaines requêtes sont mieux satisfaites par différents formats de contenu. Notez comment les différents types de fonctionnalités SERP correspondent aux différents types d’intentions de requête.

| Intention de la requête | Fonction SERP possible déclenchée |

|---|---|

| Informatif | Extrait en vedette |

| Informatif avec une seule réponse | Knowledge Graph / réponse instantanée |

| Local | Pack de cartes |

| Transactionnel | Achats |

Nous parlerons plus en détail de l’intention au chapitre 3 , mais pour l’instant, il est important de savoir que les réponses peuvent être fournies aux chercheurs dans un large éventail de formats, et comment vous structurez votre contenu peut avoir un impact sur le format dans lequel il apparaît dans la recherche.

Recherche localisée

Un moteur de recherche comme Google possède son propre index propriétaire de listes d’entreprises locales, à partir duquel il crée des résultats de recherche locaux.

Si vous effectuez un travail de référencement local pour une entreprise qui a un emplacement physique que les clients peuvent visiter (ex: dentiste) ou pour une entreprise qui se déplace pour rendre visite à ses clients (ex: plombier), assurez-vous de revendiquer, vérifier et optimiser un Fiche Google My Business gratuite .

En ce qui concerne les résultats de recherche localisés, Google utilise trois facteurs principaux pour déterminer le classement:

- Pertinence

- Distance

- Importance

Pertinence

La pertinence est la mesure dans laquelle une entreprise locale correspond à ce que recherche le chercheur. Pour vous assurer que l’entreprise fait tout ce qui est en son pouvoir pour être pertinente pour les chercheurs, assurez-vous que les informations sur l’entreprise sont complétées de manière complète et précise.

Distance

Google utilise votre géolocalisation pour mieux vous servir des résultats locaux. Les résultats de la recherche locale sont extrêmement sensibles à la proximité, qui fait référence à l’emplacement du chercheur et / ou à l’emplacement spécifié dans la requête (si le chercheur en a inclus un).

Les résultats de recherche organiques sont sensibles à l’emplacement d’un chercheur, bien que rarement aussi prononcés que dans les résultats de packs locaux.

Importance

Avec la notoriété comme facteur, Google cherche à récompenser les entreprises bien connues dans le monde réel. En plus de la proéminence hors ligne d’une entreprise, Google examine également certains facteurs en ligne pour déterminer le classement local, tels que:

Commentaires

Le nombre d’avis Google qu’une entreprise locale reçoit et le sentiment de ces avis ont un impact notable sur sa capacité à se classer dans les résultats locaux.

Citations

Une «citation d’entreprise» ou une «fiche d’entreprise» est une référence Web à la «NAP» d’une entreprise locale (nom, adresse, numéro de téléphone) sur une plateforme localisée (Yelp, Acxiom, YP, Infogroup, Localeze, etc.) .

Les classements locaux sont influencés par le nombre et la cohérence des citations d’entreprises locales. Google extrait des données d’une grande variété de sources pour constituer en permanence son index des entreprises locales. Lorsque Google trouve plusieurs références cohérentes au nom, à l’emplacement et au numéro de téléphone d’une entreprise, cela renforce la «confiance» de Google dans la validité de ces données. Cela permet ensuite à Google de montrer l’entreprise avec un degré de confiance plus élevé. Google utilise également des informations provenant d’autres sources sur le Web, telles que des liens et des articles.

Classement organique

Les meilleures pratiques de référencement s’appliquent également au référencement local, puisque Google prend également en compte la position d’un site Web dans les résultats de recherche organiques lors de la détermination du classement local.

Dans le chapitre suivant, vous découvrirez les bonnes pratiques sur la page qui aideront Google et les utilisateurs à mieux comprendre votre contenu.

[Bonus!] Engagement local

Bien qu’il ne soit pas répertorié par Google comme facteur de classement local, le rôle de l’engagement ne fera qu’augmenter avec le temps. Google continue d’enrichir les résultats locaux en intégrant des données du monde réel telles que les heures de visites populaires et la durée moyenne des visites …

Curieux de connaître l’exactitude des citations d’une entreprise locale? Moz a un outil gratuit qui peut vous aider, bien nommé Check Listing.

… et offre même aux chercheurs la possibilité de poser des questions commerciales!

Sans aucun doute, plus que jamais auparavant, les résultats locaux sont influencés par des données du monde réel. Cette interactivité est la manière dont les chercheurs interagissent avec les entreprises locales et y réagissent, plutôt que des informations purement statiques (et exploitables) telles que des liens et des citations.

Étant donné que Google souhaite proposer aux internautes les meilleures entreprises locales les plus pertinentes, il est tout à fait logique pour eux d’utiliser des mesures d’engagement en temps réel pour déterminer la qualité et la pertinence.

gratuit si vous n’en avez pas actuellement. Avec cet outil, vous pouvez soumettre des plans de site pour votre site et surveiller le nombre de pages soumises qui ont effectivement été ajoutées à l’index de Google, entre autres.

Si vous n’apparaissez nulle part dans les résultats de recherche, il existe plusieurs raisons possibles:

- Votre site est tout nouveau et n’a pas encore été exploré.

- Votre site n’est lié à aucun site Web externe.

- La navigation de votre site rend difficile pour un robot de l’explorer efficacement.

- Votre site contient du code de base appelé directives de robot d’exploration qui bloque les moteurs de recherche.

- Votre site a été sanctionné par Google pour des tactiques de spam.

Dites aux moteurs de recherche comment explorer votre site

Si vous avez utilisé Google Search Console ou l’opérateur de recherche avancée “site: domaine.com” et que vous constatez que certaines de vos pages importantes ne figurent pas dans l’index et / ou que certaines de vos pages sans importance ont été indexées par erreur, vous pouvez procéder à des optimisations. mettre en œuvre pour mieux orienter Googlebot sur la manière dont vous souhaitez que votre contenu Web soit analysé. Expliquer aux moteurs de recherche comment explorer votre site peut vous donner un meilleur contrôle de ce qui se termine dans l’index.

La plupart des gens pensent à s’assurer que Google peut trouver leurs pages importantes, mais il est facile d’oublier qu’il y a probablement des pages que vous ne voulez pas que Googlebot trouve. Ceux-ci peuvent inclure des éléments tels que les anciennes URL au contenu léger, les URL en double (comme les paramètres de tri et de filtrage pour le commerce électronique), les pages de code promotionnel spéciales, les pages de test ou de test, etc.

Pour éloigner Googlebot de certaines pages et sections de votre site, utilisez le fichier robots.txt.

Robots.txt

Les fichiers Robots.txt sont situés dans le répertoire racine des sites Web (par exemple, votredomaine.com/robots.txt) et suggèrent quelles parties de votre site les moteurs de recherche doivent et ne doivent pas explorer, ainsi que la vitesse à laquelle ils explorent votre site. , via des directives robots.txt spécifiques .

Comment Googlebot traite les fichiers robots.txt

- Si Googlebot ne trouve pas de fichier robots.txt pour un site, il procède à l’exploration du site.

- Si Googlebot trouve un fichier robots.txt pour un site, il se conformera généralement aux suggestions et procédera à l’exploration du site.

- Si Googlebot rencontre une erreur lors de la tentative d’accès au fichier robots.txt d’un site et ne peut pas déterminer s’il en existe un ou non, il n’explorera pas le site.

Optimisez le budget d’exploration!

Le budget d’exploration est le nombre moyen d’URL que Googlebot explorera sur votre site avant de partir.L’optimisation du budget d’exploration garantit donc que Googlebot ne perd pas de temps à parcourir vos pages sans importance au risque d’ignorer vos pages importantes. Le budget d’exploration est le plus important sur les très grands sites avec des dizaines de milliers d’URL , mais ce n’est jamais une mauvaise idée d’empêcher les robots d’accéder au contenu dont vous ne vous souciez certainement pas. Assurez-vous simplement de ne pas bloquer l’accès d’un robot d’exploration aux pages sur lesquelles vous avez ajouté d’autres directives, telles que les balises canoniques ou noindex. Si Googlebot est bloqué à partir d’une page, il ne pourra pas voir les instructions sur cette page.

Tous les robots Web ne suivent pas le fichier robots.txt. Les personnes avec de mauvaises intentions (par exemple, des grattoirs d’adresses e-mail) construisent des bots qui ne suivent pas ce protocole. En fait, certains acteurs malveillants utilisent des fichiers robots.txt pour trouver où vous avez localisé votre contenu privé. Bien qu’il puisse sembler logique de bloquer les robots d’exploration des pages privées telles que les pages de connexion et d’administration afin qu’ils n’apparaissent pas dans l’index, placer l’emplacement de ces URL dans un fichier robots.txt accessible au public signifie également que les personnes ayant une intention malveillante peut plus facilement les trouver. Il est préférable de NoIndexer ces pages et de les bloquer derrière un formulaire de connexion plutôt que de les placer dans votre fichier robots.txt.

Vous pouvez lire plus de détails à ce sujet dans la partie robots.txt de notre centre de formation .

Définition des paramètres d’URL dans GSC

Certains sites (les plus courants avec le commerce électronique) rendent le même contenu disponible sur plusieurs URL différentes en ajoutant certains paramètres aux URL. Si vous avez déjà effectué des achats en ligne, vous avez probablement affiné votre recherche via des filtres. Par exemple, vous pouvez rechercher des «chaussures» sur Amazon, puis affiner votre recherche par taille, couleur et style. Chaque fois que vous affinez, l’URL change légèrement:

https://www.example.com/products/women/dresses/green.htmhttps://www.example.com/products/women?category=dresses&color=greenhttps://example.com/shopindex.php?product_id= 32 & highlight = vert + robe & cat_id = 1 & sessionid = 123 $ affid = 43

Comment Google sait-il quelle version de l’URL servir aux chercheurs? Google fait un très bon travail pour déterminer l’URL du représentant par lui-même, mais vous pouvez utiliser la fonctionnalité Paramètres d’URL dans Google Search Console pour dire à Google exactement comment vous voulez qu’ils traitent vos pages. Si vous utilisez cette fonctionnalité pour indiquer à Googlebot “n’explorer aucune URL avec le paramètre ____”, vous demandez essentiellement de masquer ce contenu à Googlebot, ce qui pourrait entraîner la suppression de ces pages des résultats de recherche. C’est ce que vous voulez si ces paramètres créent des pages en double, mais pas idéal si vous voulez que ces pages soient indexées.

Les robots d’exploration peuvent-ils trouver tout votre contenu important?

Maintenant que vous connaissez certaines tactiques pour vous assurer que les robots des moteurs de recherche restent à l’écart de votre contenu sans importance, découvrons les optimisations qui peuvent aider Googlebot à trouver vos pages importantes.

Parfois, un moteur de recherche pourra trouver des parties de votre site en explorant, mais d’autres pages ou sections peuvent être masquées pour une raison ou une autre. Il est important de vous assurer que les moteurs de recherche sont en mesure de découvrir tout le contenu que vous souhaitez indexer, et pas seulement votre page d’accueil.

Posez-vous la question suivante: le bot peut-il parcourir votre site Web, et pas seulement vers lui?

Votre contenu est-il caché derrière les formulaires de connexion?

Si vous demandez aux utilisateurs de se connecter, de remplir des formulaires ou de répondre à des sondages avant d’accéder à certains contenus, les moteurs de recherche ne verront pas ces pages protégées. Un robot d’exploration ne va certainement pas se connecter.

Utilisez-vous des formulaires de recherche?

Les robots ne peuvent pas utiliser les formulaires de recherche. Certaines personnes pensent que si elles placent un champ de recherche sur leur site, les moteurs de recherche pourront trouver tout ce que leurs visiteurs recherchent.

Le texte est-il masqué dans le contenu non textuel?

Les formulaires multimédias non textuels (images, vidéo, GIF, etc.) ne doivent pas être utilisés pour afficher le texte que vous souhaitez indexer. Alors que les moteurs de recherche améliorent la reconnaissance des images, il n’y a aucune garantie qu’ils seront capables de les lire et de les comprendre pour l’instant. Il est toujours préférable d’ajouter du texte dans le balisage <HTML> de votre page Web.

Les moteurs de recherche peuvent-ils suivre la navigation de votre site?

Tout comme un robot d’exploration a besoin de découvrir votre site via des liens d’autres sites, il a besoin d’un chemin de liens sur votre propre site pour le guider de page en page. Si vous souhaitez que les moteurs de recherche trouvent une page, mais qu’elle n’est liée à aucune autre page, elle est presque invisible. De nombreux sites font l’erreur critique de structurer leur navigation de manière inaccessible aux moteurs de recherche, ce qui entrave leur capacité à figurer dans les résultats de recherche.

Erreurs de navigation courantes qui peuvent empêcher les robots d’exploration de voir l’intégralité de votre site:

- Avoir une navigation mobile qui affiche des résultats différents de la navigation de votre bureau

- Tout type de navigation où les éléments de menu ne sont pas dans le HTML, comme les navigations activées pour JavaScript. Google s’est beaucoup amélioré dans l’exploration et la compréhension de Javascript, mais ce n’est toujours pas un processus parfait . Le moyen le plus sûr de s’assurer que quelque chose est trouvé, compris et indexé par Google est de le mettre dans le HTML.

- La personnalisation, ou l’affichage d’une navigation unique vers un type spécifique de visiteur par rapport à d’autres, peut sembler être dissimulé à un robot d’exploration de moteur de recherche

- Oublier de créer un lien vers une page principale de votre site Web via votre navigation – rappelez-vous que les liens sont les chemins que les robots d’exploration suivent pour accéder aux nouvelles pages!

C’est pourquoi il est essentiel que votre site Web ait une navigation claire et des structures de dossiers URL utiles.

Avez-vous une architecture d’information propre?

L’architecture de l’information est la pratique consistant à organiser et à étiqueter le contenu d’un site Web pour améliorer l’efficacité et la trouvabilité pour les utilisateurs. La meilleure architecture d’information est intuitive, ce qui signifie que les utilisateurs ne devraient pas avoir à réfléchir très fort pour parcourir votre site Web ou pour trouver quelque chose.

Utilisez-vous des sitemaps?

Un plan de site est exactement ce à quoi il ressemble: une liste d’URL sur votre site que les robots d’exploration peuvent utiliser pour découvrir et indexer votre contenu. L’un des moyens les plus simples de s’assurer que Google trouve vos pages les plus prioritaires consiste à créer un fichier conforme aux normes de Google et à le soumettre via Google Search Console. Bien que la soumission d’un plan du site ne remplace pas la nécessité d’une bonne navigation sur le site, cela peut certainement aider les robots d’exploration à suivre un chemin vers toutes vos pages importantes.

Assurez-vous que vous n’avez inclus que les URL que vous souhaitez indexer par les moteurs de recherche et assurez-vous de donner aux robots d’exploration des directions cohérentes. Par exemple, n’incluez pas d’URL dans votre sitemap si vous avez bloqué cette URL via le fichier robots.txt ou n’incluez pas dans votre sitemap des URL qui sont des doublons plutôt que la version canonique préférée (nous fournirons plus d’informations sur la canonisation dans le chapitre 5 !).

Si aucun autre site n’est lié à votre site, vous pourrez peut-être l’indexer en soumettant votre plan de site XML dans Google Search Console. Il n’y a aucune garantie qu’ils incluront une URL soumise dans leur index, mais cela vaut la peine d’essayer!

Les robots d’exploration obtiennent-ils des erreurs lorsqu’ils tentent d’accéder à vos URL?

Lors du processus d’exploration des URL de votre site, un robot d’exploration peut rencontrer des erreurs. Vous pouvez accéder au rapport “Erreurs d’exploration” de Google Search Console pour détecter les URL sur lesquelles cela pourrait se produire – ce rapport vous montrera les erreurs de serveur et les erreurs non trouvées. Les fichiers journaux du serveur peuvent également vous montrer cela, ainsi qu’un trésor d’autres informations telles que la fréquence d’exploration, mais comme accéder et disséquer les fichiers journaux du serveur est une tactique plus avancée, nous n’en discuterons pas en détail dans le Guide du débutant, bien que vous puissiez en savoir plus ici .

Avant de pouvoir faire quoi que ce soit de significatif avec le rapport d’erreurs d’exploration, il est important de comprendre les erreurs de serveur et les erreurs “non trouvées”.

Codes 4xx: lorsque les robots des moteurs de recherche ne peuvent pas accéder à votre contenu en raison d’une erreur du client

Les erreurs 4xx sont des erreurs client, ce qui signifie que l’URL demandée contient une mauvaise syntaxe ou ne peut pas être remplie. L’une des erreurs 4xx les plus courantes est l’erreur «404 – introuvable». Celles-ci peuvent se produire en raison d’une faute de frappe d’URL, d’une page supprimée ou d’une redirection interrompue, pour ne citer que quelques exemples. Lorsque les moteurs de recherche atteignent un 404, ils ne peuvent pas accéder à l’URL. Lorsque les utilisateurs atteignent un 404, ils peuvent être frustrés et partir.

Codes 5xx: lorsque les robots des moteurs de recherche ne peuvent pas accéder à votre contenu en raison d’une erreur de serveur

Les erreurs 5xx sont des erreurs de serveur, ce qui signifie que le serveur sur lequel se trouve la page Web n’a pas réussi à répondre à la demande du chercheur ou du moteur de recherche d’accéder à la page. Dans le rapport “Erreur d’exploration” de Google Search Console, un onglet est dédié à ces erreurs. Celles-ci se produisent généralement parce que la demande d’URL a expiré. Googlebot a donc abandonné la demande. Consultez la documentation de Google pour en savoir plus sur la résolution des problèmes de connectivité du serveur.

Heureusement, il existe un moyen d’indiquer aux chercheurs et aux moteurs de recherche que votre page a déménagé – la redirection 301 (permanente).

Créez des pages 404 personnalisées!

Personnalisez votre page 404 en ajoutant des liens vers des pages importantes de votre site, une fonction de recherche de site et même des informations de contact. Cela devrait réduire la probabilité que les visiteurs rebondissent sur votre site lorsqu’ils atteignent un 404.

Supposons que vous déplaciez une page de example.com/young-dogs/ vers example.com/puppies/ . Les moteurs de recherche et les utilisateurs ont besoin d’un pont pour passer de l’ancienne URL à la nouvelle. Ce pont est une redirection 301.

| Lorsque vous implémentez un 301: | Lorsque vous n’implémentez pas de 301: | ||

|---|---|---|---|

| Lier l’équité | Transfère l’équité du lien de l’ancien emplacement de la page vers la nouvelle URL. | Sans 301, l’autorité de l’URL précédente n’est pas transmise à la nouvelle version de l’URL. | |

| Indexage | Aide Google à trouver et indexer la nouvelle version de la page. | La présence d’erreurs 404 sur votre site à elle seule ne nuit pas aux performances de recherche, mais laisser les pages de classement / trafiquées 404 peut les faire sortir de l’index, avec le classement et le trafic qui les accompagnent – yikes! | |

| Expérience utilisateur | S’assure que les utilisateurs trouvent la page qu’ils recherchent. | Permettre à vos visiteurs de cliquer sur des liens morts les mènera vers des pages d’erreur au lieu de la page prévue, ce qui peut être frustrant. |

Le code d’état 301 lui-même signifie que la page a été déplacée de manière permanente vers un nouvel emplacement, évitez donc de rediriger les URL vers des pages non pertinentes – des URL où le contenu de l’ancienne URL ne vit pas réellement. Si une page est classée pour une requête et que vous la placez sur une URL avec un contenu différent, sa position de classement peut chuter car le contenu qui l’a rendue pertinente pour cette requête particulière n’existe plus. Les 301 sont puissants – déplacez les URL de manière responsable!

Vous avez également la possibilité de 302 rediriger une page, mais cela devrait être réservé aux déplacements temporaires et dans les cas où le passage de l’équité des liens n’est pas aussi grave. Les 302 sont un peu comme un détour routier. Vous siphonnez temporairement le trafic sur un certain itinéraire, mais ce ne sera pas comme ça pour toujours.

Attention aux chaînes de redirection!

Il peut être difficile pour Googlebot d’accéder à votre page s’il doit passer par plusieurs redirections. Google appelle ces «chaînes de redirection» et recommande de les limiter autant que possible. Si vous redirigez example.com/1 vers example.com/2, puis décidez plus tard de le rediriger vers example.com/3, il est préférable d’éliminer l’intermédiaire et de rediriger simplement example.com/1 vers example.com/3.

Une fois que vous vous êtes assuré que votre site est optimisé pour l’exploration, la prochaine étape consiste à vous assurer qu’il peut être indexé.

Indexation: comment les moteurs de recherche interprètent et stockent vos pages?

Une fois que vous vous êtes assuré que votre site a été exploré, la prochaine étape consiste à vous assurer qu’il peut être indexé. C’est vrai – ce n’est pas parce que votre site peut être découvert et exploré par un moteur de recherche qu’il sera stocké dans son index. Dans la section précédente sur l’exploration, nous avons expliqué comment les moteurs de recherche découvrent vos pages Web. L’index est l’endroit où vos pages découvertes sont stockées. Une fois qu’un robot a trouvé une page, le moteur de recherche la restitue comme un navigateur le ferait. Ce faisant, le moteur de recherche analyse le contenu de cette page. Toutes ces informations sont stockées dans son index.

Lisez la suite pour en savoir plus sur le fonctionnement de l’indexation et sur la manière dont vous pouvez vous assurer que votre site est intégré à cette base de données essentielle.

Puis-je voir comment un robot d’exploration Googlebot voit mes pages?

Oui, la version mise en cache de votre page reflétera un instantané de la dernière exploration de Googlebot.

Google explore et met en cache les pages Web à différentes fréquences. Des sites plus établis et bien connus qui publient fréquemment comme https://www.nytimes.com seront explorés plus fréquemment que le site Web beaucoup moins célèbre de l’agitation de Roger the Mozbot, http://www.rogerlovescupcakes.com ( si seulement c’était réel …)

Vous pouvez voir à quoi ressemble votre version mise en cache d’une page en cliquant sur la flèche déroulante à côté de l’URL dans le SERP et en choisissant “En cache”:

Vous pouvez également afficher la version texte de votre site pour déterminer si votre contenu important est analysé et mis en cache de manière efficace.

Des pages sont-elles déjà supprimées de l’index?

Oui, les pages peuvent être supprimées de l’index! Voici quelques-unes des principales raisons pour lesquelles une URL peut être supprimée:

- L’URL renvoie une erreur “introuvable” (4XX) ou une erreur de serveur (5XX) – Cela peut être accidentel (la page a été déplacée et une redirection 301 n’a pas été configurée) ou intentionnelle (la page a été supprimée et 404 modifiée afin de le retirer de l’index)

- Une balise meta noindex a été ajoutée à l’URL – Cette balise peut être ajoutée par les propriétaires de sites pour demander au moteur de recherche d’omettre la page de son index.

- L’URL a été sanctionnée manuellement pour violation des consignes aux webmasters du moteur de recherche et, par conséquent, a été supprimée de l’index.

- L’exploration de l’URL a été bloquée avec l’ajout d’un mot de passe requis pour que les visiteurs puissent accéder à la page.

Si vous pensez qu’une page de votre site Web qui figurait auparavant dans l’index de Google ne s’affiche plus, vous pouvez utiliser l’ outil d’inspection d’URL pour connaître l’état de la page ou utiliser Explorer comme Google, qui dispose d’une fonctionnalité “Demander l’indexation” pour soumettre des URL individuelles à l’index. (Bonus: l’outil “fetch” de GSC a également une option “render” qui vous permet de voir s’il y a des problèmes avec la façon dont Google interprète votre page).

Dites aux moteurs de recherche comment indexer votre site

Directives méta robots

Les directives méta (ou “balises méta”) sont des instructions que vous pouvez donner aux moteurs de recherche concernant la manière dont vous voulez que votre page Web soit traitée.

Vous pouvez dire aux robots des moteurs de recherche des choses comme “ne pas indexer cette page dans les résultats de recherche” ou “ne transmettre aucune équité de lien à des liens sur la page”. Ces instructions sont exécutées via les balises Meta Robots dans le <head> de vos pages HTML (le plus couramment utilisé) ou via le X-Robots-Tag dans l’en-tête HTTP.

Balise Meta Robots

La balise meta robots peut être utilisée dans le <head> du code HTML de votre page Web. Il peut exclure tous ou certains moteurs de recherche. Voici les méta-directives les plus courantes, ainsi que les situations dans lesquelles vous pouvez les appliquer.

index / noindex indique aux moteurs si la page doit être explorée et conservée dans l’index d’un moteur de recherche pour la récupération. Si vous choisissez d’utiliser “noindex”, vous indiquez aux robots d’exploration que vous souhaitez que la page soit exclue des résultats de recherche. Par défaut, les moteurs de recherche supposent qu’ils peuvent indexer toutes les pages, il n’est donc pas nécessaire d’utiliser la valeur «index».

- Utilisation possible: vous pouvez choisir de marquer une page comme “noindex” si vous essayez de découper des pages fines de l’index Google de votre site (par exemple, les pages de profil générées par l’utilisateur), mais que vous souhaitez toujours qu’elles soient accessibles aux visiteurs.